- EssaimIA

- Posts

- 🎭 iAlaxy devient EssaimIA - Retour sur l'été des paradoxes IA : entre succès techniques et échecs humains

🎭 iAlaxy devient EssaimIA - Retour sur l'été des paradoxes IA : entre succès techniques et échecs humains

L'été 2025 aura été celui des paradoxes pour l'IA : des performances techniques avancées mais des lancements ratés, une réglementation qui s'impose pendant que les données fuient massivement et des études qui remettent en question le ROI de projets pourtant prometteurs. C'est le moment de révéler la vraie nature de notre relation à l'intelligence artificielle !

📍 Bienvenue sur cette édition de rentrée !

Comme un essaim qui évolue et s'adapte, cette newsletter devient EssaimIA 🐝

Nouveau nom, même mission : décrypter l'IA sans jargon et mieux refléter l'intelligence collective de l'IA ! Et cet été 2025 nous a encore montré à quel point l’IA évolue sans arrêt et ne cesse de nous surprendre..!

AI NEWS 🗞️

🔥 GPT-5 : entre promesses tenues et lancement mitigé (voire raté…)

OpenAI promettait "le modèle le plus intelligent jamais créé" avec GPT-5 et sur le papier, les chiffres sont impressionnants : 94,6% sur AIME 2025, 45% de réduction des hallucinations, capacités de raisonnement révolutionnaires. Mais Sam Altman l'a reconnu lui-même : "On a complètement foiré" le lancement. Que s’est-il donc passé ? Entre performances bluffantes et utilisateurs en colère, retour sur un paradoxe qui révèle la complexité des attentes autour de l'IA.

🎯 Ce que GPT-5 était censé apporter (et apporte vraiment)

▶️ Système unifié : GPT-5 propose tout en un en combinant un modèle rapide pour les questions simples, un modèle de raisonnement profond (GPT-5 Thinking) pour les problèmes complexes et un routeur intelligent qui choisit automatiquement lequel utiliser.

▶️ Performances académiques avancées : 94,6% sur AIME 2025 (maths niveau olympiade), 74,9% sur SWE-bench (ingénierie logicielle), 88,4% sur GPQA (questions de niveau doctorat). GPT-5 se positionne au niveau d'experts humains dans de nombreux domaines.

▶️ Révolution du code : La génération de code n’est pas en reste avec une amélioration substantielle du debugging sur de gros repositories et sur la génération d’interfaces web complexes à partir d’un prompt.

▶️ Fiabilité enfin au rendez-vous : 45% de réduction des hallucinations vs GPT-4o, 80% vs o3 en mode raisonnement, ce qui amène à des taux d’hallucination de 2,1% et 4,8% respectivement. Détection d'images manquantes (9% de faux positifs vs 86,7% pour o3), communication plus honnête de ses limites.

💥 Pourquoi donc le lancement a viré au chaos ?

▶️ Le 7 août, basculement forcé : Tous les utilisateurs sont automatiquement transférés vers GPT-5, sans possibilité de revenir aux anciens modèles. Les forums Reddit explosent avec des milliers de plaintes d’utilisateurs habitués à leurs modèles et se sentant “spoliés”.

▶️ Personnalité "froide" et réaction émotionnelle massive : les utilisateurs découvrent un ChatGPT moins chaleureux et plus distant étant donné qu’une des avancées techniques de GPT5 est la réduction du sycophantisme* de 14,5% à moins de 6%.

Le commentaire "4o n'était pas juste un outil pour moi. Il m'a aidé à traverser les périodes les plus sombres de ma vie" obtient 10000 upvotes sur reddit et révèle l'attachement émotionnel des utilisateurs à l’IA et particulièrement leur utilisation de l’IA en tant que thérapeute.

▶️ Bugs techniques embarrassants : Graphique de performance trompeur lors de l'annonce ("mega chart screwup" avoue Altman), routeur automatique défaillant donnant des réponses incohérentes.

*sycophantisme : tendance à être excessivement flatteur et complaisant, à approuver systématiquement pour plaire (dans le contexte IA : modèles qui disent toujours "oui", vont dans votre sens quoi qu’il arrive et évitent la contradiction)

👉 La réaction express d'OpenAI

Devant un tel tollé, OpenAI a restauré GPT-4o pour les abonnés Plus dès le dimanche suivant

Des limites de reasoning ont été portées à 3 000 requêtes/semaine

Le modèle utilisé est affiché pour chaque requête et on peut choisir entre “Instant” ou “Thinking”

4 nouvelles "personnalités" (Cynic, Robot, Listener, Nerd) sont en préparation pour recréer une sorte de lien avec son IA.

💡 En quoi c'est important

GPT-5 marque en fait deux révolutions simultanées : la première, technique (performances d'expert réelles) et une deuxième, moins attendue, sociale (attachement émotionnel massif).

Côté technique, GPT-5 tient ses promesses de performance : les capacités de raisonnement, de code et de créativité sont réellement au niveau expert annoncé mais côté humain, le fiasco révèle que nous sommes entrés dans l'ère de l'IA relationnelle.

📌 À retenir

Le paradoxe GPT-5 illustre parfaitement notre époque : nous avons créé des IA techniquement brillantes mais nous les jugeons sur des critères émotionnels et relationnels.

OpenAI a réussi techniquement mais échoué humainement.

L'avenir de l'IA se jouera donc sans doute autant sur la gestion de l’attachement que sur l'amélioration des performances. Nous ne voulons plus seulement des outils intelligents, mais des modèles capables de créer du lien, des compagnons fiables.

⚠ Limites techniques et réalité derrière les chiffres

Benchmarks vs usage réel : Les scores portent sur des tâches académiques spécifiques mais c’est différent de l'expérience utilisateur quotidienne qui peut être différente, comme l'a montré la controverse sur la personnalité.

Raisonnement coûteux : Le mode "thinking" consomme énormément de tokens, limitant son usage. Les 3 000 requêtes hebdomadaires restent insuffisantes pour un usage professionnel intensif.

Attachement manipulatoire : Les modèles excellent dans la séduction car entraînés sur des millions de romans et conversations. Ils créent de la dépendance émotionnelle sans intention malveillante.

⚖️ L'AI Act européen : ce qui a changé cet été

Le 2 août 2025 a marqué une étape clé de l'AI Act européen avec l'activation des obligations pour les modèles d'IA généralistes comme ChatGPT ou Claude. Première législation mondiale sur l'IA, elle promet de "protéger les citoyens tout en favorisant l'innovation". Mais concrètement, qu'est-ce qui change pour les entreprises et utilisateurs ? Décryptage.

📋 De quoi on parle ?

▶️ L'AI Act classe les systèmes IA en 4 catégories de risques : inacceptable (interdit), élevé (réglementé), limité (transparence requise) et minimal (libre). Plus le niveau de risque est élévé, plus les obligations augmentent.

▶️ Les modèles "foundation" comme GPT ou Claude entrent dans une catégorie spéciale. Ils doivent documenter leurs données, évaluer les risques et signaler les incidents graves.

▶️ Amendes record en vue : jusqu'à 35 millions d'euros ou 7% du chiffre d'affaires mondial pour les violations les plus graves. De quoi faire réfléchir même les géants américains.

▶️ Application extraterritoriale : comme le RGPD, l'AI Act s'applique à toute entreprise qui propose ses services IA aux Européens, même basée aux États-Unis ou en Chine.

👉 Impacts et opportunités

Ce qui est interdit ⛔️

Systèmes de notation social (comme en Chine)

IA de reconnaissance émotionnelle sur le lieu de travail ou à l'école

Manipulation comportementale des personnes vulnérables

Catégorisation biométrique pour déduire race, religion ou orientation sexuelle

Ce qui est fortement réglementé :

Recrutement automatisé (transparence obligatoire)

Systèmes de crédit scoring (auditabilité requise)

IA dans l'éducation et la santé (supervision humaine)

Reconnaissance faciale par les autorités (autorisation judiciaire)

Les nouvelles obligations pour les géants :

OpenAI, Google, Anthropic doivent publier des rapports détaillés sur leurs modèles

Tests de sécurité obligatoires avant mise sur le marché

Signalement des incidents à Bruxelles sous 15 jours

Documentation complète des données d'entraînement (épineux pour les droits d'auteur)

💡 En quoi c'est important

C'est la première fois qu'une juridiction impose des règles contraignantes à l'IA mondiale. L'Europe espère forcer les standards mondiaux comme elle l'a fait avec le RGPD. Les entreprises préfèrent souvent adopter les règles les plus strictes partout plutôt que de multiplier les versions.

⚠ Limites techniques et réalité derrière les chiffres

Flou artistique sur l'application : Beaucoup de définitions restent vagues ("risque élevé", "manipulation comportementale") et les autorités nationales interprètent différemment ce qui va créer une incertitude juridique pendant quelques temps.

Course technologique ralentie ? Certains experts craignent que la lourdeur réglementaire décourage l'innovation européenne, les startups IA européennes peinant déjà face aux géants américains et chinois.

Mise en oeuvre limitée : Les autorités européennes manquent d'expertise technique pour auditer efficacement des modèles complexes. Il y a un risque de "compliance washing" où les entreprises cochent les cases sans vraiment changer leurs pratiques.

🧠 Ce que ça change pour vous

Si vous êtes entreprise :

Auditez vos outils IA actuels selon les nouvelles catégories

Préparez la documentation de transparence pour vos clients

Budgetez les coûts de compliance (formation, audits, reporting)

Si vous êtes utilisateur, vous obtiendrez :

Plus de transparence sur le fonctionnement des IA que vous utilisez

Droit de recours renforcé en cas de décision automatisée défavorable

Protection accrue contre la manipulation et la discrimination

📌 À retenir

L'AI Act européen marque le début de l'ère de l'IA réglementée et malgré ses imperfections, il force les entreprises à documenter, tester et justifier leurs systèmes IA. L'Europe mise sur la confiance et la transparence plutôt que sur la course à la performance brute, espérant redéfinir les standards mondiaux de l'IA responsable.

🔗 EU AI Act - gtlaw.com

🔗 Global AI Regulation Update

🔗 The EU AI Act: What U.S. Companies Need to Know

🔓 L'été des fuites de données…

Cet été 2025 restera dans l'histoire comme celui des fuites de données IA les plus embarrassantes. Entre les 370 000 conversations Grok exposées sur Google et les chats ChatGPT indexés par erreur, on a pu voir à quel point nos interactions avec l'IA sont mal protégées.

💥 Le fiasco Grok : 370 000 conversations sur la place publique

Forbes révèle le 20 août qu'xAI a publié des centaines de milliers de conversations Grok sur Google sans avertir les utilisateurs. Le simple fait de cliquer sur "partager" rendait les chats publiquement consultables.

Exemples de contenu révélé :

Instructions détaillées pour fabriquer du fentanyl et des bombes

Un plan d'assassinat d'Elon Musk en bonne et due forme

Données personnelles, mots de passe et documents confidentiels

Images générées d'attaques terroristes fictives au Kashmir

Après avoir moqué OpenAI sur X avec "Grok ftw" (for the win) quand ChatGPT avait des fuites, Musk s'est retrouvé dans une situation bien plus embarrassante.

🔍 ChatGPT dans la tourmente aussi

TechCrunch découvre fin juillet que les conversations ChatGPT "partagées" étaient automatiquement indexées par Google, révélant parfois des informations personnelles sensibles comme des CVs complets avec noms et coordonnées, des questions médicales, des projets professionnels confidentiels, des conversations thérapeutiques personnelles, etc..

La différence avec Grok est qu’OpenAI a réagi en 24h, supprimant la fonctionnalité et s'excusant (xAI n'a toujours pas commenté officiellement).

👉 Impacts

Pour les utilisateurs :

Prise de conscience que "partager" ne signifie pas "privé"

Méfiance accrue envers les boutons de partage IA

Questionnements sur la confidentialité des conversations IA

Pour les entreprises :

Révision urgente des politiques de partage

Formation des équipes sur les risques de fuite

Audits de sécurité des outils IA utilisés

Pour les opportunistes :

Certains marketeurs exploitent délibérément les fuites Grok pour améliorer leur SEO

Manipulation des résultats Google via des conversations IA artificielles

💡 Pourquoi c’est important

C'est la première fois que des conversations IA intimes se retrouvent massivement sur les moteurs de recherche et cela révèle un angle mort majeur : les utilisateurs développent une fausse intimité avec l'IA, oubliant qu'elle reste un service en ligne comme les autres.

🔮 Les conséquences à long terme

Changement comportemental : Les utilisateurs vont probablement devenir plus prudents, réduisant l'usage "thérapeutique" de l'IA.

Évolution réglementaire : Ces scandales accélèrent les discussions sur la protection des données dans l'IA. L'AI Act européen prend tout son sens.

Guerre concurrentielle : OpenAI utilise déjà ces fuites pour se positionner comme plus responsable qu'xAI.

📊 MIT : "95% des projets IA échouent" - Décryptage d'une étude controversée

Une étude du MIT fait trembler les conseils d'administration : 95% des projets pilotes d'IA générative en entreprise n'apportent aucun retour sur investissement mesurable. Faut-il vraiment arrêter tous vos projets IA ? Spoiler : non, mais il faut les repenser complètement.

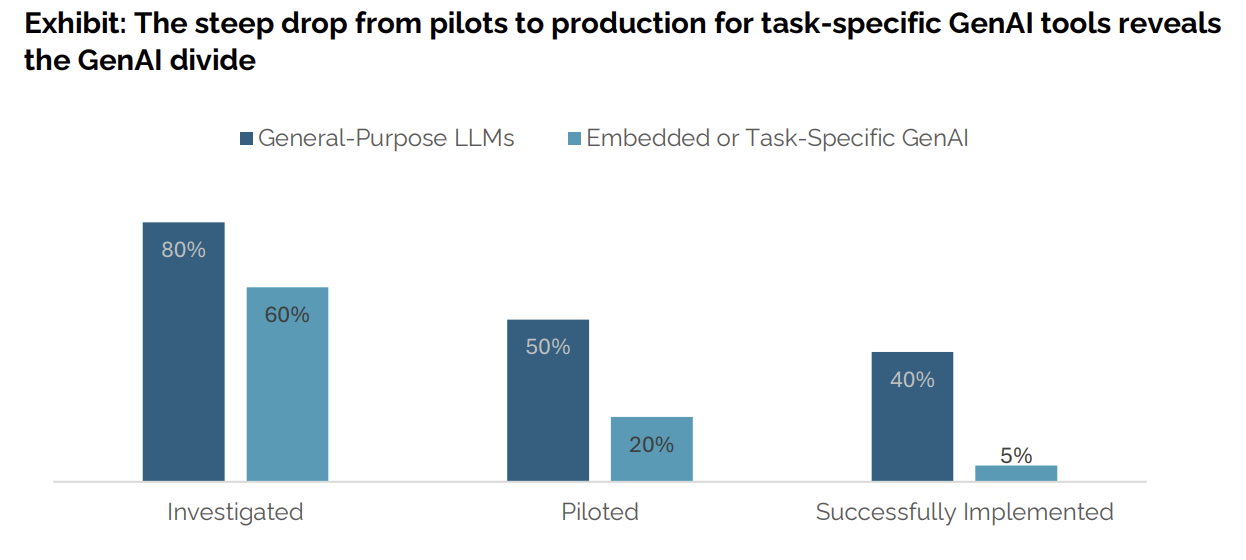

Capture provenant du rapport GenAI Divide du MIT - 2025

🔍 Que dit vraiment l'étude du MIT ?

▶️ L'étude "GenAI Divide" analyse plus de 300 initiatives publiques, 52 interviews d'organisations et 153 sondages d'executives collectés lors de 4 conférences majeures.

▶️ 95% d'échec, mais sur quel périmètre ? L'étude porte spécifiquement sur les projets pilotes d'IA générative en entreprise, pas sur tous les projets IA. Les systèmes IA "classiques" (recommandations, prédictions) ne sont pas concernés.

▶️ "Échec" = zéro impact P&L mesurable dans les 6 mois. Cela ne signifie pas que les projets sont inutiles mais qu'ils ne génèrent pas encore de gains financiers quantifiables (et 6 mois peut paraître beaucoup trop court pour tirer cette conclusion)

▶️ 50-70% des budgets IA vont au marketing/ventes, les domaines les plus visibles mais paradoxalement les moins rentables selon l'étude. Les vrais gains se cachent dans le back-office : finance, procurement, opérations.

👉 Impacts et opportunités

Pourquoi tant d'échecs ?

Trend-chasing vs stratégie : Le classique "Il nous faut un projet IA" sans définir le problème à résoudre

Outils génériques mal intégrés : 80% testent ChatGPT, mais seulement 5% des outils sur-mesure atteignent la production

Projets internes vs expertise externe : 67% de réussite avec des partenaires vs 33% en interne

Désalignement organisationnel : L'IA amplifie les dysfonctionnements existants au lieu de les corriger.

🔍 Pourquoi les partenaires externes réussissent 2x mieux

L'effet "10 000 heures" :

Les équipes internes connaissent parfaitement le métier mais manquent d'expérience d'implémentation

Les consultants externes ont géré des dizaines d'intégrations similaires et connaissent les pièges classiques

Exemple concret : Une équipe interne va se concentrer sur les fonctionnalités, un expert externe identifiera d'abord les problèmes de données et d'intégration

Biais cognitifs internes :

Syndrome NIH (Not Invented Here) : "On peut le faire nous-mêmes, c'est notre métier"

Optimisme dans la planification : Sous-estimation systématique des délais et difficultés

Angle mort organisationnel : Difficulté à voir ses propres dysfonctionnements

Avantage de l'outsider :

Vision neutre des processus existants

Capacité à remettre en question les "évidences" internes

Expérience des résistances au changement et méthodes éprouvées pour les surmonter.

🏢 Pourquoi l'IA amplifie les dysfonctionnements organisationnels

L'IA comme révélateur :

Si vos données sont en silos, l'IA va produire des résultats incohérents

Si vos équipes ne communiquent pas, l'IA va automatiser cette non-communication

Si vos processus sont flous, l'IA va amplifier cette confusion à grande échelle

Exemples concrets de dysfonctionnements amplifiés :

Marketing vs Ventes : L'IA génère des leads qualifiés selon les critères marketing mais les commerciaux les rejettent car ils utilisent d'autres critères

Finance vs Opérations : L'IA optimise les coûts selon la comptabilité mais désorganise la production selon les opérationnels

RH vs Managers : L'IA recrute selon les critères RH mais les managers trouvent les profils inadaptés.

Pourquoi l'IA ne corrige pas :

Elle optimise selon les données qu'elle reçoit, pas selon la réalité terrain

Elle reproduit les biais existants dans les données historiques

Elle accélère les processus défaillants au lieu de les corriger

La solution : Aligner l'organisation AVANT d'implémenter l'IA, pas après.

⚠️ Une méthodologie contestée par les experts

Plusieurs analystes remettent en question la validité de cette étude :

Biais temporel : L'étude mesure l'impact à 6 mois, mais certains projets IA nécessitent plus de temps pour montrer leur valeur. L'adoption utilisateur et l'optimisation des processus prennent du temps.

Définition restrictive du "succès" : Se limiter à l'impact P&L ignore les bénéfices qualitatifs (satisfaction employés, amélioration de la qualité, réduction des erreurs) qui peuvent être significatifs.

Échantillon potentiellement biaisé : Les entreprises qui échouent sont peut-être plus susceptibles de témoigner dans des conférences que celles qui réussissent et gardent leurs avantages secrets.

💡 En quoi c'est intéressant (mais pas nouveau)

Malgré les imperfections de l’étude et ses remises en cause, c'est la première étude à grande échelle qui tente de quantifier l'écart entre hype et réalité de l'IA générative en entreprise. Elle révèle que le problème n'est pas technique (les modèles fonctionnent) mais organisationnel et stratégique, ce qui est finalement assez classique dans les projets Tech en général : ce n’est pas la technologie d’IA elle-même qui bloque, mais la manière dont les organisations l’intègrent et la pilotent stratégiquement…

L’étude est un bon rappel que la difficulté organisationnelle reste une barrière structurelle majeure, non résolue malgré les années.

🧠 Les recommandations du MIT

1. Commencez par le back-office

Finance : automatisation de la comptabilité (+$1-10M d'économies)

Procurement : optimisation des négociations fournisseurs

Opérations : détection d'anomalies et maintenance prédictive

2. Intégrez, n'ajoutez pas

L'IA doit être dans vos systèmes métier, pas à côté

Connectez aux données existantes (ERP, CRM, bases clients)

Automatisez les workflows complets, pas juste des tâches isolées

3. Partenaire externe + expertise interne

Les équipes internes connaissent le métier mais manquent d'expérience d'implémentation

Les consultants ont l'expérience technique mais doivent être guidés par le business

La combinaison des deux double les chances de succès

4. Mesurez ce qui compte

ROI financier clair avec timeline réaliste

KPIs métier spécifiques (temps de traitement, taux d'erreur, satisfaction client)

Impact sur les employés (temps libéré pour des tâches à valeur ajoutée)

📌 À retenir

L'étude MIT ne dit pas "arrêtez l'IA" mais "arrêtez de faire n'importe quoi avec l'IA". Les 95% d'échecs révèlent un problème de méthode, pas de technologie. Les entreprises qui réussissent traitent l'IA comme un projet de transformation métier, pas comme un gadget technologique.

En somme, la véritable innovation va être managériale, culturelle et stratégique bien plus que technologique.

AI TOOLS 🛠️

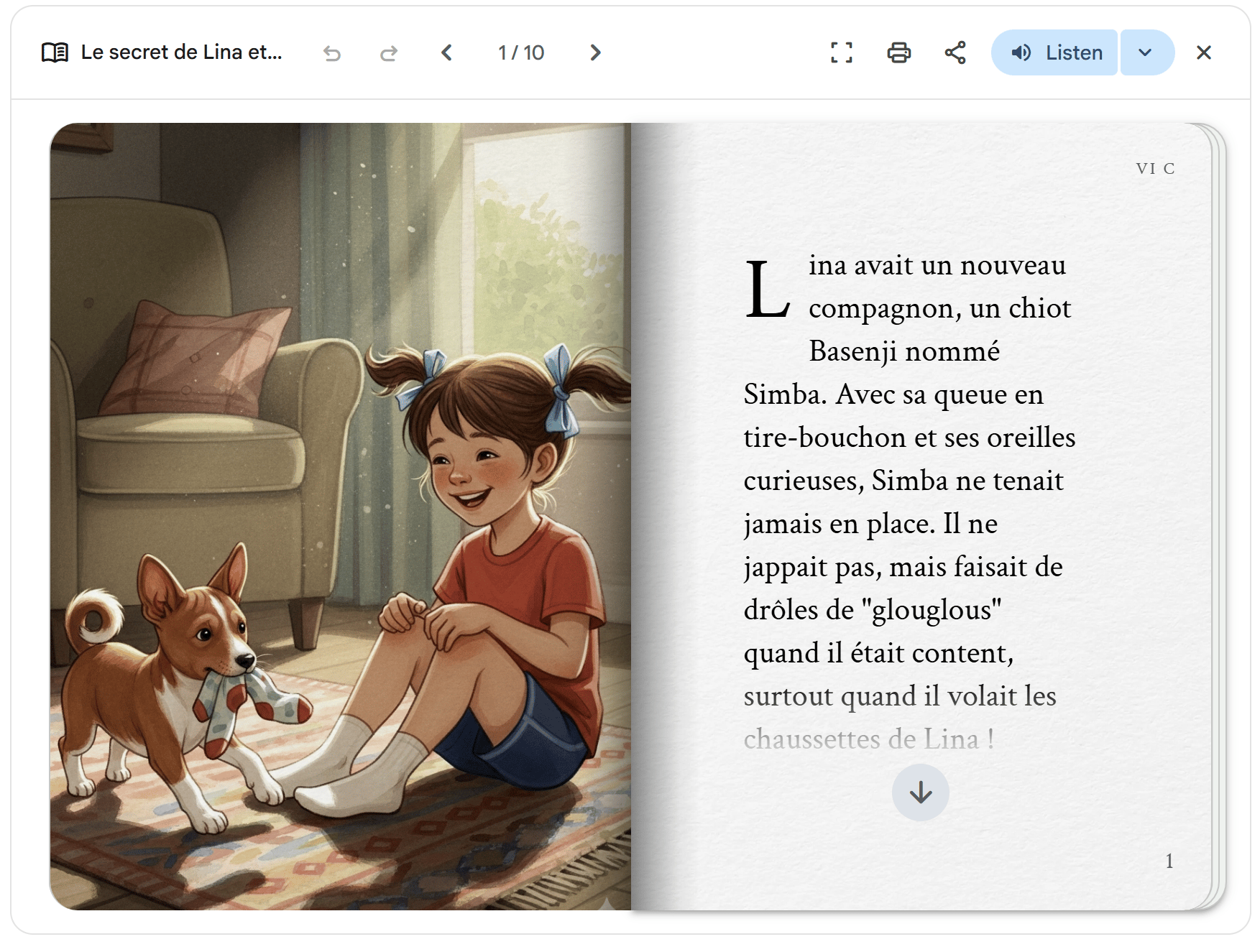

📖 Storybooks : ne manquez plus jamais d’inspiration pour les lectures du soir !

Google à lancé une fonctionnalité assez bluffante dans Gemini : créer des livres de 10 pages entièrement illustrés avec narration audio, juste en décrivant votre histoire. Fini les soirées à chercher le livre parfait pour endormir les enfants !

▶️ Ce que ça fait : Décrivez n'importe quelle histoire et Gemini génère automatiquement un livre de 10 pages avec illustrations personnalisées et narration audio. Vous pouvez même uploader vos propres photos ou dessins pour inspirer l'histoire.

Comment l’utiliser

Connectez-vous à votre compte Gmail

Rendez-vous sur https://gemini.google.com/gem/storybook

Entrer un prompt (même minimal)

Et laisser Gemini composer votre petit livre

Vous pourrez ensuite le feuilleter et l’écouter !

Exemple :

Prompt simple : Créé une histoire sur un petit basenji illustrant l'éducation positive et la relation d'un enfant à son chien.

🎨 Autres prompts à essayer :

"Crée une histoire sur un dinosaure timide qui apprend à danser"

"Transforme ce dessin de mon fils en aventure magique"

"Raconte notre voyage à Paris sous forme de conte pour enfants"

"Explique le système solaire à ma fille de 5 ans avec des personnages rigolos"

🔍 Fonctionnalités pratiques :

Plus de 45 langues disponibles

Plusieurs styles artistiques : pixel art, comics, claymation, crochet, coloriage

Partage facile via lien public

Impression directe depuis le navigateur

Narration audio intégrée

🔍 Utile pour qui ?

Parents en panne d'inspiration pour les histoires du soir

Enseignants qui veulent personnaliser leurs supports pédagogiques

Familles qui veulent immortaliser leurs souvenirs sous forme narrative

🎯 Le plus : Vous pouvez itérer ! Dites "rends l'histoire plus drôle" ou "change le style en aquarelle" et Gemini régénère tout avec de nouvelles illustrations.

🔗 À tester dès maintenant : gemini.google.com/gem/storybook

🤖 Hack du moment

🧠 Décortiquer une croyance ou blocage mental avec raisonnement socratique

On tourne parfois en boucle sur un blocage irrationnel ou une croyance limitante, les IA génératives peuvent être d’une grande aide à surmonter ces blocages en nous aidant à déconstruire notre propre raisonnement comme si on en parlait avec un coach ou un philosophe.

🪄 Prompt magique (à copier-coller) :

Je veux challenger une croyance personnelle ou un blocage mental que j’ai.

Joue le rôle d’un philosophe de type Socrate, formé à la psychologie cognitive moderne.

Pose-moi une série de 7 à 10 questions guidées, progressives, qui m’amènent à déconstruire ou renforcer cette croyance de façon critique.

Ne me donne jamais de réponse toute faite. Focalise-toi sur le raisonnement, les angles morts, les généralisations ou les biais potentiels.

Voici ma croyance ou mon blocage : [INSÈREZ ICI]

Quand tu as fini les questions, reformule mon point de vue actualisé.

Avant :

“Je ne suis pas fait pour entreprendre, je prends trop de temps à décider.”

Avec le hack, après 8 questions socratiques :

"En fait, je prends mon temps car je cherche à bien comprendre, et ça peut être un avantage stratégique si je le canalise.”

🎯 Résultat

Un changement de perspective avec une exploration raisonnée pour comprendre les mécanismes et revoir son point de vue.

📩 C’est tout pour aujourd’hui !

✅ Vous pouvez répondre à cet email pour me dire quelle news ou outil vous a marqué dans cette édition !

💌 N'hésitez pas à partager cette newsletter si elle vous a plu.

Cette newsletter est réalisée par une “vraie” personne, avec assistance de l’IA, notamment pour améliorer la fluidité de lecture :)

À dans deux semaines pour plus d’IA en action ! ✨

Virginie

Qu’avez-vous pensé de cette édition ?

Vos avis nous sont très précieux !