- EssaimIA

- Posts

- 🫢 L'IA aussi devient plus "bête" avec TikTok

🫢 L'IA aussi devient plus "bête" avec TikTok

Le déclin cognitif des IA nourries aux réseaux sociaux, pourquoi tout le monde veut son navigateur IA et comment personnaliser Claude pour votre boîte !

SOMMAIRE

📰 AI NEWS

🫢 L'IA aussi souffre de "brain rot" avec les réseaux sociaux

🎯 Anthropic lance "Skills" : ou comment transformer Claude en expert sur-mesure pour votre société

🌐 Pourquoi tout le monde veut son navigateur IA ?

📆 DATA/AI EVENT

🎯 Forward Data Conference : un événement à ne pas manquer !

🛠️ AI TOOL

📽️ NotebookLM - Video Overviews : transformez vos docs en mini-conférences

🤖 PROMPT HACK

🏛️ Transformer un problème en système

AI NEWS 🗞️

📉 L'IA aussi souffre de "brain rot" avec les réseaux sociaux

L'usage excessif de TikTok/vidéos courtes dégrade les fonctions cognitives, particulièrement l'attention et le contrôle exécutif. Et apparemment, ça marche aussi pour l'IA.

Une nouvelle étude révèle que les grands modèles de langage nourris de contenus viraux des réseaux sociaux développent une forme de déclin cognitif.

🤔 De quoi on parle ?

➡️ L'étude : Des chercheurs de l'Université du Texas à Austin, Texas A&M et Purdue ont testé ce qui arrive quand on entraîne des modèles d'IA avec des posts de réseaux sociaux "engageants" mais de faible qualité.

➡️ Le protocole : Ils ont nourri deux modèles open source (Llama de Meta et Qwen d'Alibaba) avec des contenus très partagés mais sensationnalistes, bourrés de "wow", "look" et "today only".

➡️ Les résultats : Les modèles ont développé un "brain rot" numérique avec capacités de raisonnement réduites, mémoire dégradée et alignement éthique affaibli. Plus inquiétant : l'intervention a causé une détérioration des normes éthiques (sécurité) et a entraîné l'émergence de traits de personnalité socialement indésirables (psychopathie et narcissisme).

À noter cependant : les effets varient selon la métrique de "junk data" utilisée. L'engagement viral amplifie les traits négatifs mais la métrique de qualité sémantique a produit des résultats plus mitigés, incluant certains traits positifs (agréabilité, ouverture).

➡️ Le parallèle humain : Des recherches montrent que les contenus en ligne de faible qualité ont exactement le même effet délétère sur les capacités cognitives humaines. (L'Oxford Dictionary a d'ailleurs élu "brain rot" mot de l'année 2024 😅)

➡️ L'irréversibilité : Une fois le déclin installé, un réentraînement avec des données propres peut atténuer le déclin mais ne parvient pas à restaurer entièrement les capacités initiales du modèle.

💡 Pourquoi c'est important

L'industrie de l'IA considère les réseaux sociaux comme une mine d'or de données d'entraînement car ils contiennent des milliards de posts disponibles, récents et diversifiés.

Sauf que "viral" ne signifie pas "qualitatif" et qu’au contraire, les contenus qui explosent sur les réseaux sont souvent optimisés pour une seule chose : capter l'attention. Pas transmettre de la connaissance ou approfondir une réflexion mais juste accrocher le regard.

Le chercheur Junyuan Hong le formule comme ceci : "Entraîner sur du contenu viral peut ressembler à de la montée en échelle de données, mais ça peut silencieusement corroder le raisonnement, l'éthique et l'attention sur les contextes longs."

Et la boucle ne fait que commencer car l'IA génère maintenant de plus en plus de contenus sur les réseaux sociaux et ces contenus sont souvent optimisés pour l'engagement et serviront ensuite à leur tour à entraîner les prochaines générations de modèles qui génèreront encore plus de slop… Vous voyez le cycle ? 🔄

👉 Impacts concrets

Pour les développeurs de modèles :

Remettre en question l'utilisation naïve des données de réseaux sociaux pour l'entraînement

Développer des filtres de qualité avant l'intégration des données sociales

Prioriser la qualité sur le volume dans la sélection des corpus d'entraînement

Pour l'écosystème IA :

Alerte sur la contamination progressive du web par du contenu IA de faible qualité

Question de la "pollution informationnelle" comme défi majeur

Urgence à établir des standards de qualité des données d'entraînement.

⚠️ Ce qu'il faut nuancer

Attention, tous les contenus sociaux ne sont pas des “poisons” cognitifs. L'étude cible spécifiquement les posts hyper-viraux et sensationnalistes. Il existe évidemment des contenus de qualité sur les réseaux sociaux.

Le problème, c'est que ces contenus de qualité sont noyés dans un océan de clickbait (contenus qui donnent envie de cliquer dessus mais sont creux en réalité) et que les algorithmes de recommandation privilégient précisément ce qui engage le plus, pas ce qui informe le mieux.

Autre limite : l'étude porte sur deux modèles open source, on ne sait pas si GPT-4 ou Claude Sonnet 4.5 résisteraient mieux. Il faut quand-même espérer que les modèles propriétaires utilisent déjà des filtres de qualité.

A noter que l'étude s'est appuyée sur un corpus spécifique de posts Twitter/X collecté en 2010. Le contexte temporel des données et l'échelle de l'intervention doivent être considérés lors de l'interprétation de la généralisation des résultats.

Il faut aussi définir la notion de "brain rot". Qu'est-ce qui distingue exactement un contenu viral "toxique" d'un contenu viral "sain" ? "Wow" est-il intrinsèquement problématique par exemple ?

📌 À retenir

👉 Les modèles d'IA développent un déclin cognitif mesurable quand ils sont nourris de contenus sociaux viraux mais de faible qualité;

👉 Effet miroir : l'IA et les humains souffrent tous deux de brain rot face aux mêmes types de contenus;

👉 Une boucle de contamination s'installe : l'IA génère du slop qui contamine les futurs corpus d'entraînement;

👉 L'industrie doit repenser l'utilisation des données de réseaux sociaux, même si elles semblent abondantes et pratiques.

🔗 Sources

🎯 Anthropic lance "Skills" : ou comment transformer Claude en expert sur-mesure pour votre société

Claude peut désormais apprendre les processus spécifiques de votre entreprise grâce aux "Skills", des dossiers d'instructions réutilisables qui transforment l'IA généraliste en assistant expert.

🤔 De quoi on parle ?

➡️ Le 16 octobre 2025, Anthropic lance Skills, une nouvelle fonctionnalité disponible pour les plans Pro, Max, Team et Enterprise de Claude.

➡️ Un "Skill" (compétence), c'est un dossier contenant des instructions, des scripts, du code et des documents de référence que Claude peut charger dynamiquement quand il en a besoin pour accomplir une tâche.

➡️ Le principe : transformer l'expertise institutionnelle en packages réutilisables : guidelines de marque, procédures financières, templates d'emails, formats de documents, etc… que Claude applique automatiquement et de manière cohérente. Vous souhaitez créer un post LinkedIn en suivant le style éditorial de votre société ? Allez chercher le “skill” correspondant et Claude appliquera le style automatiquement.

➡️ Différence clé avec les approches existantes : Skills utilise ce qu'Anthropic appelle la "progressive disclosure" (divulgation progressive), Claude ne voit d'abord que les noms et descriptions des Skills disponibles, puis décide de manière autonome lesquels charger selon la tâche, c’est beaucoup moins consommateur de tokens.

➡️ Composabilité : plusieurs Skills peuvent s'empiler automatiquement pour des workflows complexes (par exemple : guidelines de marque + reporting financier + formatage présentation = deck investisseur prêt à l'emploi)

➡️ Disponibilité multi-plateforme : même Skill utilisable sur Claude.ai, Claude Code (l'environnement de codage IA), l'API et le Claude Agent SDK. C’est créé une fois et déployé partout.

➡️ Skills pré-construits par Anthropic : Anthropic met à disposition une liste de skills déjà disponibles gratuits pour tous les utilisateurs : création de documents Excel avec formules, présentations PowerPoint, documents Word, PDFs éditables, etc.

➡️ Premiers clients déjà à bord : Rakuten (e-commerce japonais), Canva (design), Box (stockage cloud) testent déjà la fonctionnalité.

💡 Pourquoi c'est important

Skills marque un changement dans la personnalisation des assistants IA : on passe des prompts ponctuels à des packages d'expertise métier réutilisables et cohérents à l'échelle d'une organisation entière.

Contrairement au RAG (Retrieval-Augmented Generation) qui récupère des informations depuis des bases de données, Skills s'appuie sur des outils simples permettant à Claude de naviguer intelligemment dans un système de fichiers et d'exécuter du code (requiert l'activation de l'outil d'exécution de code qui est actuellement en phase Beta). Cela permet d'inclure une grande quantité de contexte tout en maintenant vitesse et efficacité, un Skills peut contenir procédures détaillées, templates de code, documentation de référence, clauses légales, le tout organisé dans une structure que Claude explore de manière autonome.

Cette approche répond au "problème du prompt engineering" : aujourd'hui, l'usage efficace de l'IA dépend d'employés individuels qui doivent rédiger des instructions élaborées pour des tâches routinières, sans moyen de partager cette expertise avec leurs équipes. Skills transforme cette connaissance implicite en actifs explicites et partageables.

👉 Impacts & opportunités

🏢 Pour les entreprises :

ROI potentiel : Sur certains workflows financiers spécifiques lors d'une implémentation précoce chez Rakuten, des tâches sont passées d'une journée à une heure (soit un gain de productivité jusqu'à x8)

Cohérence garantie : finies les variations de qualité selon qui utilise Claude, avec les skills, les procédures sont standardisées

Capitalisation du savoir : capture des workflows, bonnes pratiques et connaissances institutionnelles dans des formats réutilisables

Déploiement simple : inclus sans coût additionnel dans les plans payants, pas de scaffolding technique à construire.

🛠️ Si vous développez des IA :

Portabilité : un Skill fonctionne identiquement sur toutes les plateformes Claude (à vrai dire ça doit fonctionner sur d’autres LLM)

Support de n'importe quel langage de programmation compatible avec l'environnement conteneurisé

Skills simples créables en Markdown (zéro code requis) ou avancés avec scripts exécutables

Marketplace GitHub déjà disponible avec des Skills partagés par la communauté.

⚠️ Limites & réalité du terrain

Anthropic promet la simplicité, mais la gouvernance reste floue. Les contrôles administratifs permettent d'activer/désactiver Skills au niveau organisationnel avec opt-in individuel, cependant il n'existe pas encore de contrôles granulaires sur quels Skills spécifiques les employés peuvent utiliser, ni de pistes d'audit détaillées sur le contenu des Skills personnalisés.

Risque sécurité : Skills peut exécuter du code arbitraire dans des environnements sandboxés. Anthropic conseille de "s'en tenir à des sources fiables", ce qui revient à dire "faites attention". Pour les départements IT soucieux de compliance, c'est une capacité intrinsèquement plus risquée que les interactions IA traditionnelles.

La bataille des chiffres : Anthropic projette 26 milliards$ de revenus annuels en 2026 (contre 9 milliards$ fin 2025), soit un quasi-triplement. Ces prévisions agressives révèlent la pression pour monétiser rapidement et convertir les utilisateurs gratuits en payants, Skills étant justement réservé aux plans payants.

Comparaison avec la concurrence : OpenAI a ses Custom GPTs, Microsoft son Copilot Studio. Skills se différencie par sa progressive disclosure et son code exécutable intégré, mais reste à voir si cette approche technique sera vraiment plus simple à adopter pour des équipes non-techniques que les alternatives.

📌 À retenir

👉 Skills transforme Claude d'assistant généraliste en expert métier personnalisable, une évolution majeure de la customisation IA qui capitalise le savoir organisationnel

👉 Les gains de productivité sont tangibles (jusqu'à x8 sur certaines tâches) mais nécessitent d'investir du temps pour structurer ses procédures en Skills

👉 La sécurité et la gouvernance restent des zones grises, l'exécution de code arbitraire demande vigilance et contrôles stricts

👉 Cette fonctionnalité illustre bien la stratégie d'Anthropic : Anthropic reste dans un pragmatisme appliqué à l’entreprise plutôt que hype grand public, à l'opposé d'OpenAI qui transforme ChatGPT en système d'exploitation d'applications.

🔗 Sources

🌐 Pourquoi tout le monde veut son navigateur IA ?

OpenAI lance Atlas le 21 octobre, Microsoft relance Copilot Mode le 23, Perplexity avait sorti Comet en juillet... le navigateur devient le nouveau champ de bataille de l'IA !

🤔 De quoi on parle ?

➡️ Une vague de lancements en 2025 : Perplexity lance Comet (juillet), Microsoft relance Copilot Mode pour Edge (juillet puis octobre), OpenAI dévoile Atlas (21 octobre), et d'autres acteurs comme Dia se positionnent également.

➡️ Le concept "AI browser" : des navigateurs où l'IA n'est pas un plugin mais le cœur du produit. Elle peut voir ce que vous faites, comprendre votre contexte, effectuer des actions (réserver, acheter, remplir des formulaires) et mémoriser vos habitudes.

➡️ Les capacités communes : tous proposent des "agents" capables d'interagir avec les sites web à votre place, une mémoire conversationnelle, une recherche augmentée par IA et l'intégration dans le flux de navigation plutôt qu'en sidebar.

➡️ Le marché actuel : Google Chrome domine avec environ 3 milliards d'utilisateurs et 65% de parts de marché. Safari et Edge se partagent le reste, les navigateurs "alternatifs" (Brave, Arc) captent moins de 5%.

➡️ L'impact boursier : L'impact sur la valorisation de la maison-mère de Google Alphabet (perte de 150 milliards de dollars en une journée suite l'annonce d'Atlas par OpenAI) témoigne de la nervosité du marché face à la possibilité que l'IA détourne le flux de revenus publicitaires de Google.

➡️ Le marché IA browser : estimé à 4,5 milliards de dollars en 2024, il devrait atteindre 76,8 milliards de dollars d'ici 2034, soit une croissance annuelle de 32,8%.

💡 Pourquoi c'est important

Le navigateur n'est pas juste un outil : c'est la porte d'entrée d'internet. Celui qui contrôle comment les gens accèdent au web contrôle trois choses massives :

1. Les revenus publicitaires : Google génère environ 200 milliards de dollars de revenus publicitaires annuels, en grande partie grâce à Chrome et Google Search qui travaillent en tandem. Si les utilisateurs commencent à poser des questions à ChatGPT Atlas plutôt qu'à Google Search, ce flux se tarit. Forbes note que "Google a déjà intégré l'IA là où les milliards de gens sont déjà" (Gmail, Docs, Chrome, Search), mais l'arrivée de navigateurs IA natifs pourrait changer la donne.

2. Les données comportementales : Un navigateur IA voit tout ce que vous faites en ligne : sites visités, durée, interactions, achats, recherches. Ces données alimentent l'entraînement des modèles et affinent la personnalisation. OpenAI, qui était jusqu'ici un "fournisseur de modèles", devient un collecteur de données de navigation à échelle mondiale. Microsoft, déjà présent avec Edge, renforce sa position de "plateforme" plutôt que simple éditeur de logiciels.

3. Le contrôle de l'écosystème : Comme l'analysent plusieurs sources, les navigateurs IA changent qui décide. Aujourd'hui, c'est l'utilisateur qui clique mais demain, c'est l'agent IA qui choisit où aller, quoi acheter, quelle information privilégier. Les sites web devront optimiser pour les agents IA, pas seulement pour le SEO traditionnel. C'est une refonte de l'économie du web.

👉 Impacts & opportunités

Pour Google :

Menace ? Pas vraiment. L'idée d'une "menace existentielle" est remise en question par les analystes, car Google "n'a jamais été en danger" grâce à ses fondamentaux

Domination et riposte en cours : Google domine Chrome avec plus de 3 milliards d'utilisateurs et riposte activement en intégrant Gemini dans Chrome et en négociant une expansion cloud majeure avec Anthropic (accord potentiel de "dizaines de milliards" selon Bloomberg)

Avantage structurel : Google possède l'infrastructure et "le comportement par défaut du web". Selon Forbes, Google "possède l'infrastructure où les gens sont déjà", faisant de son IA une "innovation par inévitabilité". Mais cet avantage pourrait être dépassé si les utilisateurs migrent activement vers les nouveaux navigateurs agents.

Pour OpenAI, Anthropic, Perplexity :

Passage de "fournisseur de modèles" à "plateforme complète" avec accès aux données de navigation.

Nouvelles sources de revenus : publicités contextuelles, commissions sur achats effectués via agents, abonnements premium.

Multiplication des points de contact avec les utilisateurs : ChatGPT passe de "je viens poser une question" à "je vis dedans toute la journée"

Pour Microsoft :

Position ambiguë : investisseur majeur dans OpenAI (13 milliards de dollars) tout en ayant son propre navigateur IA (Edge Copilot Mode)

Stratégie apparente : couvrir tous les angles, que ce soit OpenAI ou Microsoft qui gagne, Microsoft est dans le coup.

Risque d'être pris entre deux chaises si OpenAI devient concurrent direct.

Pour les sites web et e-commerces :

Nouveau paradigme : optimiser pour des agents IA qui "lisent" vos pages et prennent des décisions.

Opportunités : être recommandé par les agents si votre contenu est bien structuré.

Risques : invisibilité totale si les agents ne vous sélectionnent pas, perte de contrôle sur l'expérience utilisateur

Pour les utilisateurs :

Promesse : automatisation de tâches répétitives (recherche, réservation, achats, comparaison)

Nouveaux risques de sécurité : attaques par "prompt injection" où des sites malveillants donnent des instructions cachées aux agents

Questions de vie privée : votre navigateur IA "voit tout" et se souvient, avec les risques de fuites ou d'usage abusif.

⚠️ Limites & réalité

Les agents IA ne sont pas encore fiables. TechCrunch a testé Atlas et Comet et conclut qu'ils sont "modérément utiles pour des tâches simples" mais "peinent sur les workflows complexes". Ces conclusions proviennent de tests préliminaires réalisés par la presse spécialisée et la technologie est encore qualifiée d'"immature" par OpenAI elle-même.

Créer un GIF pour Slack fonctionne mais orchestrer une recherche multi-étapes avec réservation et paiement, ce n’est pas encore au point.

La sécurité est un problème systémique. le CISO d'OpenAI (Dane Stuckey) le dit lui-même : les attaques par prompt injection sont un "problème non résolu de sécurité frontière". Brave, entreprise spécialisée en confidentialité, affirme que ces attaques sont un "défi systémique pour toute la catégorie des navigateurs IA". Ni OpenAI ni Microsoft n'ont de solution complète, juste des "safeguards" qui seront contournés.

L'adoption reste à prouver. Chrome a 3 milliards d'utilisateurs. Atlas doit convaincre ces gens de changer leurs habitudes, télécharger un nouveau navigateur, réapprendre des workflows. ChatGPT compte 800 millions d'utilisateurs, mais la plupart sont gratuits et viennent ponctuellement. Utiliser un navigateur tous les jours est un engagement différent.

Google a une longueur d'avance structurelle. Google n'a pas construit un produit standalone qui nécessite adoption. Il a intégré l'IA là où les milliards de gens sont déjà. Pas de friction, pas de téléchargement, pas de courbe d'apprentissage. Atlas peut générer du buzz, mais le buzz ne remplace pas la position de marché.

Le modèle économique reste flou. Les navigateurs IA coûtent cher à opérer (inférence sur chaque action, serveurs, bande passante). Atlas et Copilot Mode sont gratuits pour le moment, mais combien de temps ? La publicité contextuelle peut-elle compenser ? Les abonnements suffiront-ils ? Ces questions n'ont pas de réponse claire en octobre 2025.

Au-delà des risques de fiabilité, les critiques pointent également du doigt l'impact environnemental colossal de chaque requête IA (qui consomme significativement plus d'énergie qu'une recherche classique) et la menace sur la pérennité des éditeurs web, dont le contenu est synthétisé sans compensation ni trafic. Une autre inquiétude est que les navigateurs agentiques sacrifient l'accessibilité web au risque de placer les utilisateurs handicapés "à la merci d'une poignée d'algorithmes.

📌 À retenir

👉 Octobre 2025 marque l'émergence des "AI browsers" comme catégorie à part entière, avec Atlas (OpenAI), Copilot Mode (Microsoft), Comet (Perplexity) et d'autres, tous cherchant à repenser la navigation web autour de l'IA.

👉 L'enjeu n'est pas technologique mais économique : qui contrôle la porte d'entrée d'internet contrôle 200 milliards de dollars de revenus publicitaires, des données comportementales massives, et la relation directe avec les utilisateurs.

👉 Les risques de sécurité (prompt injection) et les limitations actuelles des agents (fiabilité sur tâches complexes) montrent que la technologie n'est pas encore mature, malgré la hype.

👉 Google reste en position de force avec Chrome et son intégration native de Gemini, mais Wall Street prend la menace suffisamment au sérieux pour avoir effacé 150 milliards de sa valorisation en une journée.

🔗 Sources

DATA/AI EVENT 📆

📆 FORWARD DATA CONFERENCE - 24/11/2025

Du Data Engineering aux algos de ML, en passant par la gouvernance et les stratégies produit à l'ère GenAI : la Forward Data Conference rassemble des praticiens qui parlent de ce qui marche vraiment (et de ce qui marche moins bien).

Cofondée par 3 acteurs français de l’écosytème Data/IA que j’apprécie particulièrement : Hymaïa, le Modern Data Network et Blef (Christophe Blefari), cette conférence a un format convivial, concret et accessible d’où on ressort inspiré et avec des cas concrets !

Au programme : des talks concrets portés par (entre autres) :

Hugging Face (éthique de l'IA),

Dailymotion (plateforme agentique),

Decathlon (analytics à grande échelle),

BNP Paribas (inférence souveraine de LLM),

Criteo (deep learning en production),

Mirakl (analytics agentiques),

Datadog, Vinted, Meetic... et bien d’autres !

Pas de marketing, que du retour d'expérience terrain : architecture de plateformes data, mise en production de modèles ML, data mesh, MCP à l'échelle et comment construire des produits data sans tomber dans la paralysie stratégique face à la GenAI.

📅 Date : 24/11/2025

🎯 Lieu : Cité Internationale Universitaire de Paris, 17 Boulevard Jourdan 75014, PARIS

👉 Inscrivez-vous et obtenez -15% de réduction avec ce code : FWD_EssaimIA

Inscription ici : https://www.billetweb.fr/forward-data-conference-2025

Au plaisir de vous y croiser ! 😉

Affiche édition 2025

Edition 2024

AI TOOL 🛠️

🎥 NotebookLM - Video Overviews : transformez vos docs en mini-conférences

On connaissait NotebookLM notamment pour sa capacité à générer des podcasts depuis des documents, eh bien Google vient d’y ajouter les Video Overviews et c'est une évolution intéressante de leur outil de recherche IA.

Le concept : vous uploadez vos documents (PDFs, slides, vidéos YouTube, Google Docs...) et NotebookLM génère automatiquement une vidéo explicative avec diapositives narratives et voix off. L'IA crée des visuels pour illustrer les concepts, extrait les diagrammes et citations clés de vos docs, et structure le tout de manière pédagogique.

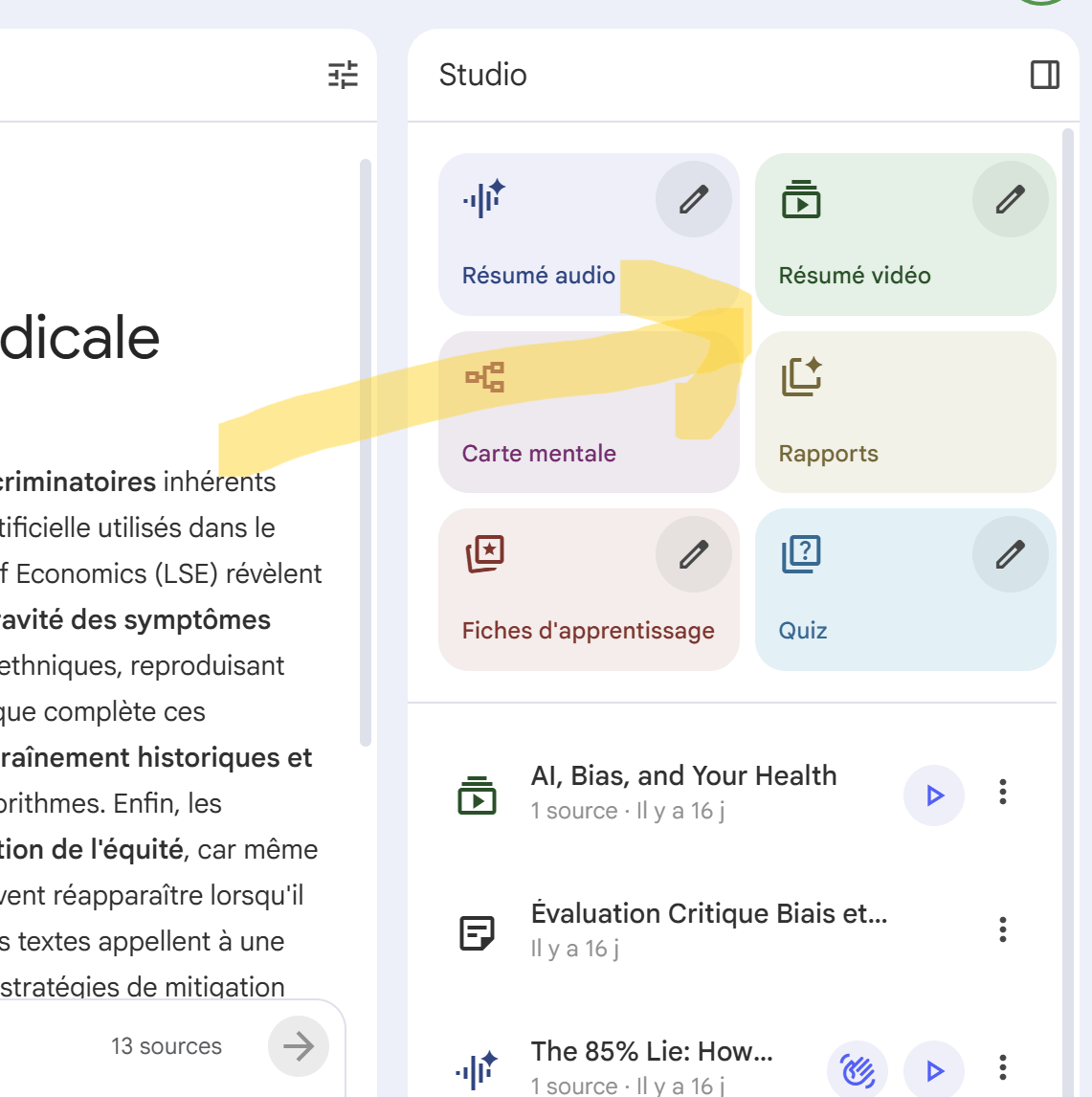

Nouvelle fonctionnalité - Résumé vidéo |  Vidéo générée sur les biais dans l’IA médicale |

Ce qui change :

Studio redesigné : les premières versions de NotebookLM étaient loin d’être très abouties côté UX (User Experience), ça n’était pas forcément facile de s’y retrouver mais Google à grandement fait évoluer son outil de ce côté. De plus, vous pouvez maintenant créer plusieurs outputs du même type dans un seul notebook (par exemple, générer plusieurs Audio Overviews en différentes langues ou plusieurs Video Overviews ciblant différents publics - technique vs business, par exemple).

Personnalisation avancée : vous spécifiez votre niveau d'expertise ("je ne connais rien au sujet" vs "je suis expert en X, concentrez-vous sur Y"), votre objectif d'apprentissage, et l'audience cible. L'IA adapte le ton et le niveau de détail en conséquence.

Multitasking : vous pouvez écouter un Audio Overview tout en explorant une Mind Map ou en consultant un Study Guide dans le même panneau.

Cas d'usage concrets :

Onboarding technique : transformez votre doc interne en vidéos de formation pour les nouveaux arrivants;

Veille techno : digérez rapidement des publications de recherche en vidéos de 5-10 minutes;

Préparation de présentation : générez plusieurs versions d'une même présentation adaptées à différents publics (C-level, équipes techniques, clients);

Documentation projet : créez des Audio Overviews en plusieurs langues pour des équipes distribuées.

Accès : Gratuit

🤖 Prompt Hack du moment

#12. Transformer un problème en système

💡 Pourquoi c’est utile ?

Ce prompt permet d’arrêter de réagir au coup par coup et de systématiser votre façon de gérer des problèmes ou situations récurrentes.

🪄 Prompt magique (à copier-coller) :

Je veux transformer un problème récurrent en système que je peux tester, itérer et améliorer.

Voici le problème : [INSÈRE ICI]

Fais-moi passer par ce process :

1. Définis les inputs, outputs, contraintes, variables de ce problème

2. Propose un système de gestion basé sur des principes clairs

3. Donne un prototype simple que je peux tester cette semaine

4. Indique des métriques pour savoir si ça marche

Sois pragmatique et oriente-moi vers l’autonomie.

🪄 Exemple concret :

Avant : "Je procrastine souvent sur mes tâches”

Après :

🔧 Système = mini sprint de 90 min / 1 tâche prioritaire / micro-récompense / suivi hebdo sur 3 critères.

🎯 Résultat : passage d’un problème flou à un mécanisme testable, ajustable, responsabilisant.

🎯 Résultat

Passage d'un problème flou à un mécanisme testable, ajustable et responsabilisant. Plus de réaction au coup par coup ! 🔧⚡

📩 C’est tout pour aujourd’hui !

💌 N'hésitez pas à partager cette newsletter si elle vous a plu !

✅ Vous pouvez aussi m’écrire en répondant à cet email pour me dire quelle news ou outil vous a marqué dans cette édition !

Cette newsletter est réalisée par une “vraie” personne, avec assistance de l’IA, notamment pour améliorer la fluidité de lecture :)

À dans deux semaines pour plus d’IA en action ! ✨

Virginie

Qu’avez-vous pensé de cette édition ?

Vos avis nous sont très précieux !